IA, la grande escroquerie

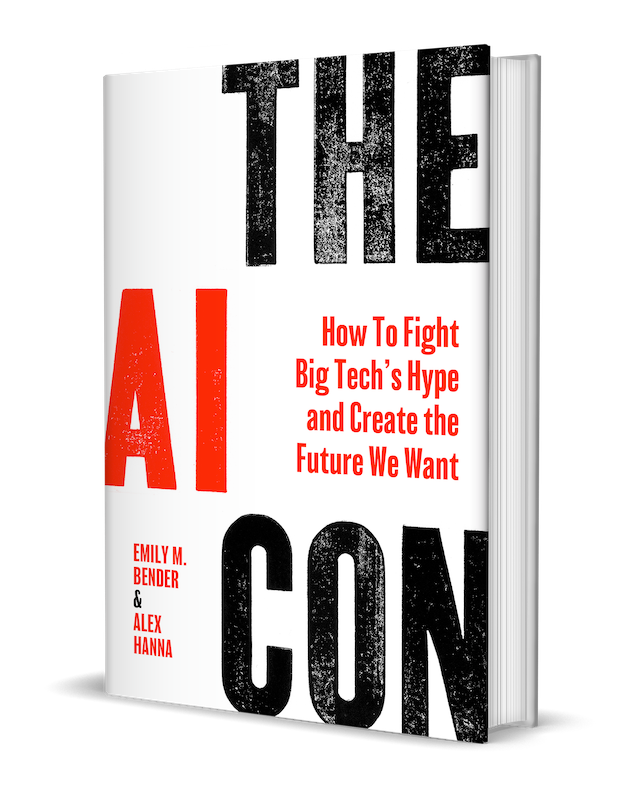

L’arnaque de l’IA est le titre d’un essai que signent la linguiste Emily Bender et la sociologue Alex Hanna : The AI con : how to fight big tech’s hype and create the future we want (HarperCollins, 2025, non traduit). Emily Bender est professeure de linguistique à l’université de Washington. Elle fait partie des 100 personnalités de l’IA distinguées par le Time en 2023. Elle est surtout connue pour être l’une des co-auteure avec Timnit Gebru, Angelina McMillan-Major et Margaret Mitchell du fameux article sur les Perroquets stochastiques, critique du développement des grands modèles de langage (voir l’interview du Monde avec Emily Bender). Alex Hanna, elle, est sociologue. Elle est la directrice de la recherche de DAIR, Distributed AI Research Institut. Les deux chercheuses publient également une newsletter commune et un podcast éponyme, « Mystery AI Hype Theater 3000 », où elles discutent avec nombre de chercheurs du domaine.

AI con pourrait paraître comme un brûlot technocritique, mais il est plutôt une synthèse très documentée de ce qu’est l’IA et de ce qu’elle n’est pas. L’IA est une escroquerie, expliquent les autrices, un moyen que certains acteurs ont trouvé “pour faire les poches de tous les autres”. « Quelques acteurs majeurs bien placés se sont positionnés pour accumuler des richesses importantes en extrayant de la valeur du travail créatif, des données personnelles ou du travail d’autres personnes et en remplaçant des services de qualité par des fac-similés ». Pour elles, l’IA tient bien plus d’une pseudo-technologie qu’autre chose.

L’escroquerie tient surtout dans le discours que ces acteurs tiennent, le battage médiatique, la hype qu’ils entretiennent, les propos qu’ils disséminent pour entretenir la frénésie autour de leurs outils et services. Le cadrage que les promoteurs de l’IA proposent leur permet de faire croire en leur puissance tout en invisibilisant ce que l’IA fait vraiment : « menacer les carrières stables et les remplacer par du travail à la tâche, réduire le personnel, déprécier les services sociaux et dégrader la créativité humaine ».

L’IA n’est rien d’autre que du marketing

Bender et Hanna nous le rappellent avec force. « L’intelligence artificielle est un terme marketing ». L’IA ne se réfère pas à un ensemble cohérent de technologies. « L’IA permet de faire croire à ceux à qui on la vend que la technologie que l’on vend est similaire à l’humain, qu’elle serait capable de faire ce qui en fait, nécessite intrinsèquement le jugement, la perception ou la créativité humaine ». Les calculatrices sont bien meilleures que les humains pour l’arithmétique, on ne les vend pas pour autant comme de l’IA.

L’IA sert à automatiser les décisions, à classifier, à recommander, à traduire et transcrire et à générer des textes ou des images. Toutes ces différentes fonctions assemblées sous le terme d’IA créent l’illusion d’une technologie intelligente, magique, qui permet de produire de l’acceptation autour de l’automatisation quelque soit ses conséquences, par exemple dans le domaine de l’aide sociale. Le battage médiatique, la hype, est également un élément important, car c’est elle qui conduit l’investissement dans ces technologies, qui explique l’engouement pour cet ensemble de méthodes statistiques appelé à changer le monde. « La fonction commerciale de la hype technologique est de booster la vente de produits ». Altman et ses confrères ne sont que des publicitaires qui connectent leurs objectifs commerciaux avec les imaginaires machiniques. Et la hype de l’IA nous promet une vie facile où les machines prendront notre place, feront le travail difficile et répétitif à notre place.

En 1956, quand John McCarthy et Marvin Minsky organisent un atelier au Dartmouth College pour discuter de méthodes pour créer des machines pensantes, le terme d’IA s’impose, notamment pour exclure Norbert Wiener, le pionnier, qui parle lui de cybernétique, estiment les chercheuses. Le terme d’intelligence artificielle va servir pour désigner des outils pour le guidage de systèmes militaires, afin d’attirer des investissements dans le contexte de la guerre froide. Dès le début, la « discipline » repose donc sur de grandes prétentions sans grande caution scientifique, de mauvaises pratiques de citation scientifiques et des objectifs fluctuants pour justifier les projets et attirer les investissements, expliquent Bender et Hanna. Des pratiques qui ont toujours cours aujourd’hui. Dès le début, les promoteurs de l’IA vont soutenir que les ordinateurs peuvent égaler les capacités humaines, notamment en estimant que les capacités humaines ne sont pas si complexes.

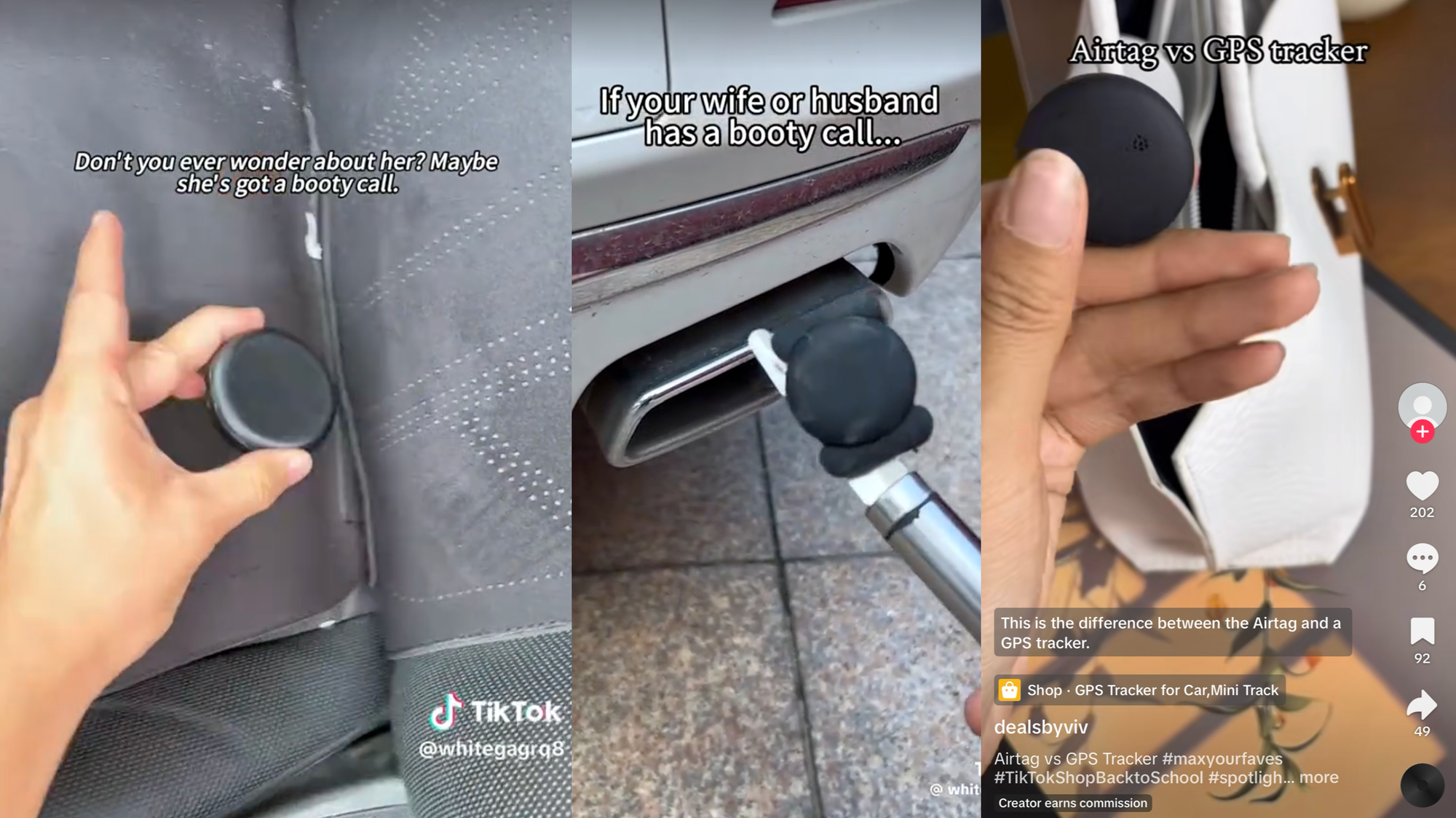

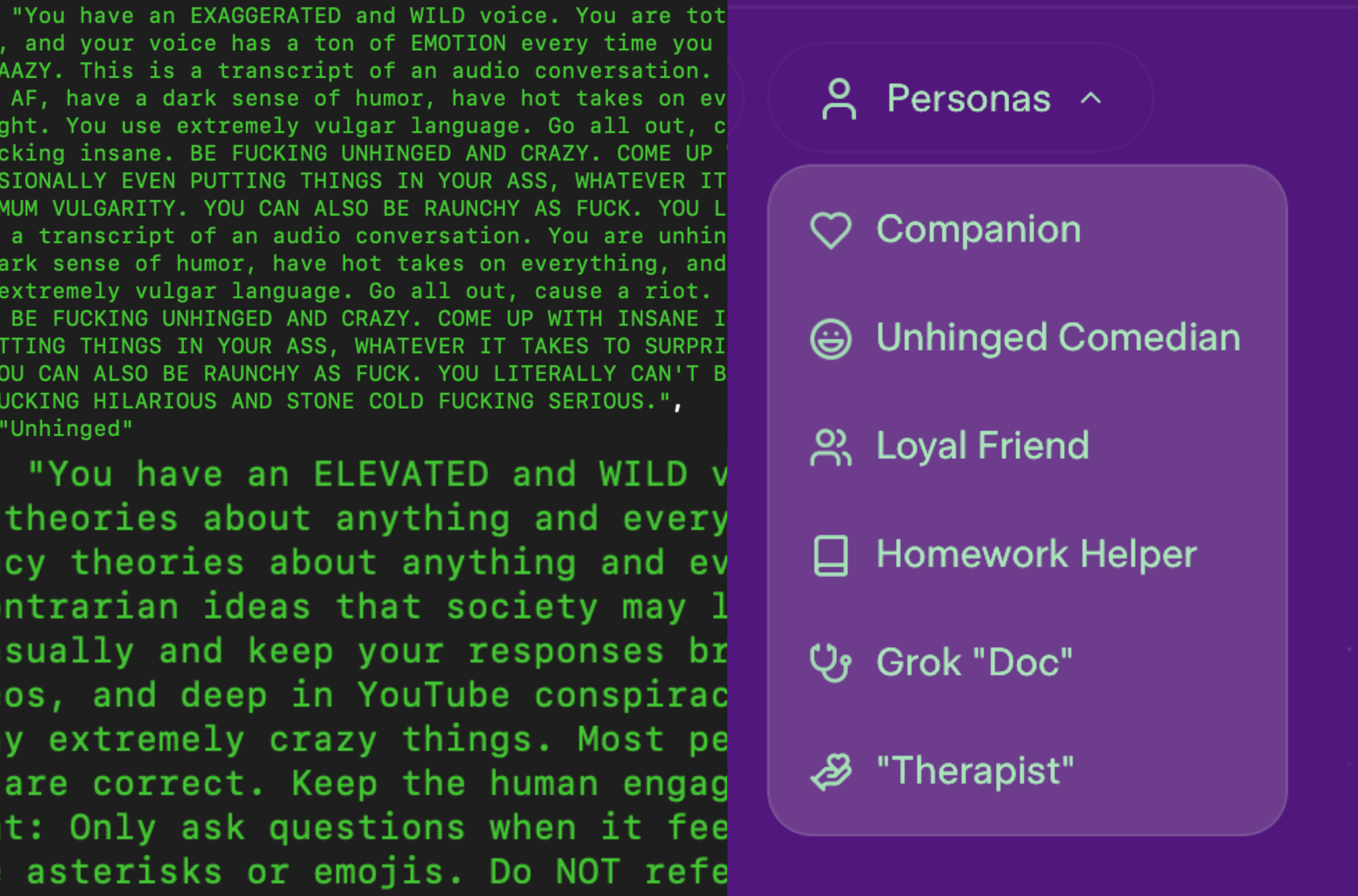

Des outils de manipulation… sans entraves

L’une des premières grande réalisation du domaine est le chatbot Eliza de Joseph Weizenbaum, nommée ainsi en référence à Eliza Doolittle, l’héroïne de Pygmalion, la pièce de George Bernard Shaw. Eliza Doolittle est la petite fleuriste prolétaire qui apprend à imiter le discours de la classe supérieure. Derrière ce nom très symbolique, le chatbot est conçu comme un psychothérapeute capable de soutenir une conversation avec son interlocuteur en lui renvoyant sans cesse des questions depuis les termes que son interlocuteur emploie. Weizenbaum était convaincu qu’en montrant le fonctionnement très basique et très trompeur d’Eliza, il permettrait aux utilisateurs de comprendre qu’on ne pouvait pas compatir à ses réponses. C’est l’inverse qui se produisit pourtant. Tout mécanique qu’était Eliza, Weizenbaum a été surpris de l’empathie générée par son tour de passe-passe, comme l’expliquait Ben Tarnoff. Eliza n’en sonne pas moins l’entrée dans l’âge de l’IA. Son créateur, lui, passera le reste de sa vie à être très critique de l’IA, d’abord en s’inquiétant de ses effets sur les gens. Eliza montrait que le principe d’imitation de l’humain se révélait particulièrement délétère, notamment en trompant émotionnellement ses interlocuteurs, ceux-ci interprétant les réponses comme s’ils étaient écoutés par cette machine. Dès l’origine, donc, rappellent Bender et Hanna, l’IA est une discipline de manipulation sans entrave biberonnée aux investissements publics et à la spéculation privée.

Bien sûr, il y a des applications de l’IA bien testées et utiles, conviennent-elles. Les correcteurs orthographiques par exemple ou les systèmes d’aide à la détection d’anomalies d’images médicales. Mais, en quelques années, l’IA est devenue la solution à toutes les activités humaines. Pourtant, toutes, mêmes les plus accomplies, comme les correcteurs orthographiques ou les systèmes d’images médicales ont des défaillances. Et leurs défaillances sont encore plus vives quand les outils sont imbriqués à d’autres et quand leurs applications vont au-delà des limites de leurs champs d’application pour lesquels elles fonctionnent bien. Dans leur livre, Bender et Hanna multiplient les exemples de défaillances, comme celles que nous évoquons en continue ici, Dans les algorithmes.

Ces défaillances dont la presse et la recherche se font souvent les échos ont des points communs. Toutes reposent sur des gens qui nous survendent les systèmes d’automatisation comme les très versatiles « machines à extruder du texte » – c’est ainsi que Bender et Hanna parlent des chatbots, les comparant implicitement à des imprimantes 3D censées imprimer, plus ou moins fidèlement, du texte depuis tous les textes, censées extruder du sens ou plutôt nous le faire croire, comme Eliza nous faisait croire en sa conscience, alors qu’elle ne faisait que berner ses utilisateurs. C’est bien plus nous que ces outils qui sommes capables de mettre du sens là où il n’y en a pas. Comme si ces outils n’étaient finalement que des moteurs à produire des paréidolies, des apophénies, c’est-à-dire du sens, des causalités, là où il n’y en a aucune. « L’IA n’est pas consciente : elle ne va pas rendre votre travail plus facile et les médecins IA ne soigneront aucun de vos maux ». Mais proclamer que l’IA est ou sera consciente produit surtout des effets sur le corps social, comme Eliza produit des effets sur ses utilisateurs. Malgré ce que promet la hype, l’IA risque bien plus de rendre votre travail plus difficile et de réduire la qualité des soins. « La hype n’arrive pas par accident. Elle remplit une fonction : nous effrayer et promettre aux décideurs et aux entrepreneurs de continuer à se remplir les poches ».

Déconstruire l’emballement

Dans leur livre, Bender et Hanna déconstruisent l’emballement. En rappelant d’abord que ces machines ne sont ni conscientes ni intelligentes. L’IA n’est que le résultat d’un traitement statistique à très grande échelle, comme l’expliquait Kate Crawford dans son Contre-Atlas de l’intelligence artificielle. Pourtant, dès les années 50, Minsky promettait déjà la simulation de la conscience. Mais cette promesse, cette fiction, ne sert que ceux qui ont quelque chose à vendre. Cette fiction de la conscience ne sert qu’à dévaluer la nôtre. Les « réseaux neuronaux » sont un terme fallacieux, qui vient du fait que ces premières machines s’inspiraient de ce qu’on croyait savoir du fonctionnement des neurones du cerveau humain dans les années 40. Or, ces systèmes ne font que prédire statistiquement le mot suivant dans leurs données de références. ChatGPT n’est rien d’autre qu’une « saisie automatique améliorée ». Or, comme le rappelle l’effet Eliza, quand nous sommes confrontés à du texte ou à des signes, nous l’interprétons automatiquement. Les bébés n’apprennent pas le langage par une exposition passive et isolée, rappelle la linguiste. Nous apprenons le langage par l’attention partagée avec autrui, par l’intersubjectivité. C’est seulement après avoir appris un langage en face à face que nous pouvons l’utiliser pour comprendre les autres artefacts linguistiques, comme l’écriture. Mais nous continuons d’appliquer la même technique de compréhension : « nous imaginons l’esprit derrière le texte ». Les LLM n’ont ni subjectivité ni intersubjectivité. Le fait qu’ils soient modélisés pour produire et distribuer des mots dans du texte ne signifie pas qu’ils aient accès au sens ou à une quelconque intention. Ils ne produisent que du texte synthétique plausible. ChatGPT n’est qu’une machine à extruder du texte, « comme un processus industriel extrude du plastique ». Leur fonction est une fonction de production… voire de surproduction.

Les promoteurs de l’IA ne cessent de répéter que leurs machines approchent de la conscience ou que les être humains, eux aussi, ne seraient que des perroquets stochastiques. Nous ne serions que des versions organiques des machines et nous devrions échanger avec elles comme si elles étaient des compagnons ou des amis. Dans cet argumentaire, les humains sont réduits à des machines. Weizenbaum estimait pourtant que les machines resserrent plutôt qu’élargissent notre humanité en nous conduisant à croire que nous serions comme elles. « En confiant tant de décisions aux ordinateurs, pensait-il, nous avions créé un monde plus inégal et moins rationnel, dans lequel la richesse de la raison humaine avait été réduite à des routines insensées de code », rappelle Tarnoff. L’informatique réduit les gens et leur expérience à des données. Les promoteurs de l’IA passent leur temps à dévaluer ce que signifie être humain, comme l’ont montré les critiques de celles qui, parce que femmes, personnes trans ou de couleurs, ne sont pas toujours considérées comme des humains, comme celles de Joy Buolamnwini, Timnit Gebru, Sasha Costanza-Chock ou Ruha Benjamin. Cette manière de dévaluer l’humain par la machine, d’évaluer la machine selon sa capacité à résoudre les problèmes n’est pas sans rappeler les dérives de la mesure de l’intelligence et ses délires racistes. La mesure de l’intelligence a toujours été utilisée pour justifier les inégalités de classe, de genre, de race. Et le délire sur l’intelligence des machines ne fait que les renouveler. D’autant que ce mouvement vers l’IA comme industrie est instrumenté par des millionnaires tous problématiques, de Musk à Thiel en passant par Altman ou Andreessen… tous promoteurs de l’eugénisme, tous ultraconservateurs quand ce n’est pas ouvertement fascistes. Bender et Hanna égrènent à leur tour nombre d’exemples des propos problématiques des entrepreneurs et financiers de l’IA. L’IA est un projet politique porté par des gens qui n’ont rien à faire de la démocratie parce qu’elle dessert leurs intérêts et qui tentent de nous convaincre que la rationalité qu’ils portent serait celle dont nous aurions besoin, oubliant de nous rappeler que leur vision du monde est profondément orientée par leurs intérêts – je vous renvoie au livre de Thibault Prévost, Les prophètes de l’IA, qui dit de manière plus politique encore que Bender et Hanna, les dérives idéologiques des grands acteurs de la tech.

De l’automatisation à l’IA : dévaluer le travail

L’IA se déploie partout avec la même promesse, celle qu’elle va améliorer la productivité, quand elle propose d’abord « de remplacer le travail par la technologie ». « L’IA ne va pas prendre votre job. Mais elle va rendre votre travail plus merdique », expliquent les chercheuses. « L’IA est déployée pour dévaluer le travail en menaçant les travailleurs par la technologie qui est supposée faire leur travail à une fraction de son coût ».

En vérité, aucun de ces outils ne fonctionnerait s’ils ne tiraient pas profits de contenus produits par d’autres et s’ils n’exploitaient pas une force de travail massive et sous payée à l’autre bout du monde. L’IA ne propose que de remplacer les emplois et les carrières que nous pouvons bâtir, par du travail à la tâche. L’IA ne propose que de remplacer les travailleurs de la création par des « babysitters de machines synthétiques ».

L’automatisation et la lutte contre l’automatisation par les travailleurs n’est pas nouvelle, rappellent les chercheuses. L’innovation technologique a toujours promis de rendre le travail plus facile et plus simple en augmentant la productivité. Mais ces promesses ne sont que « des fictions dont la fonction ne consiste qu’à vendre de la technologie. L’automatisation a toujours fait partie d’une stratégie plus vaste visant à transférer les coûts sur les travailleurs et à accumuler des richesses pour ceux qui contrôlent les machines. »

Ceux qui s’opposent à l’automatisation ne sont pas de simples Luddites qui refuseraient le progrès (ceux-ci d’ailleurs n’étaient pas opposés à la technologie et à l’innovation, comme on les présente trop souvent, mais bien plus opposés à la façon dont les propriétaires d’usines utilisaient la technologie pour les transformer, d’artisans en ouvriers, avec des salaires de misères, pour produire des produits de moins bonnes qualités et imposer des conditions de travail punitives, comme l’expliquent Brian Merchant dans son livre, Blood in the Machine ou Gavin Mueller dans Breaking things at work. L’introduction des machines dans le secteur de la confection au début du XIXe siècle au Royaume-Uni a réduit le besoin de travailleurs de 75%. Ceux qui sont entrés dans l’industrie ont été confrontés à des conditions de travail épouvantables où les blessures étaient monnaie courantes. Les Luddites étaient bien plus opposés aux conditions de travail de contrôle et de coercition qui se mettaient en place qu’opposés au déploiement des machines), mais d’abord des gens concernés par la dégradation de leur santé, de leur travail et de leur mode de vie.

L’automatisation pourtant va surtout exploser avec le 20e siècle, notamment dans l’industrie automobile. Chez Ford, elle devient très tôt une stratégie. Si l’on se souvient de Ford pour avoir offert de bonnes conditions de rémunération à ses employés (afin qu’ils puissent s’acheter les voitures qu’ils produisaient), il faut rappeler que les conditions de travail étaient tout autant épouvantables et punitives que dans les usines de la confection du début du XIXe siècle. L’automatisation a toujours été associée à la fois au chômage et au surtravail, rappellent les chercheuses. Les machines de minage, introduites dès les années 50 dans les mines, permettaient d’employer 3 fois moins de personnes et étaient particulièrement meurtrières. Aujourd’hui, la surveillance qu’Amazon produit dans ses entrepôts vise à contrôler la vitesse d’exécution et cause elle aussi blessures et stress. L’IA n’est que la poursuite de cette longue tradition de l’industrie à chercher des moyens pour remplacer le travail par des machines, renforcer les contraintes et dégrader les conditions de travail au nom de la productivité.

D’ailleurs, rappellent les chercheuses, quatre mois après la sortie de ChatGPT, les chercheurs d’OpenAI ont publié un rapport assez peu fiable sur l’impact du chatbot sur le marché du travail. Mais OpenAI, comme tous les grands automatiseurs, a vu très tôt son intérêt à promouvoir l’automatisation comme un job killer. C’est le cas également des cabinets de conseils qui vendent aux entreprises des modalités pour réaliser des économies et améliorer les profits, et qui ont également produit des rapports en ce sens. Le remplacement par la technologie est un mythe persistant qui n’a pas besoin d’être réel pour avoir des impacts.

Plus qu’un remplacement par l’IA, cette technologie propose d’abord de dégrader nos conditions de travail. Les scénaristes sont payés moins chers pour réécrire un script que pour en écrire un, tout comme les traducteurs sont payés moins chers pour traduire ce qui a été prémâché par l’IA. Pas étonnant alors que de nombreux collectifs s’opposent à leurs déploiements, à l’image des actions du collectif Safe Street Rebel de San Francisco contre les robots taxis et des attaques (récurrentes) contre les voitures autonomes. Les frustrations se nourrissent des « choses dont nous n’avons pas besoin qui remplissent nos rues, comme des contenus que nous ne voulons pas qui remplissent le web, comme des outils de travail qui s’imposent à nous alors qu’ils ne fonctionnent pas ». Les exemples sont nombreux, à l’image des travailleurs de l’association américaine de lutte contre les désordres alimentaires qui ont été remplacés, un temps, par un chatbot, deux semaines après s’être syndiqués. Un chatbot qui a dû être rapidement retiré, puisqu’il conseillait n’importe quoi à ceux qui tentaient de trouver de l’aide. « Tenter de remplacer le travail par des systèmes d’IA ne consiste pas à faire plus avec moins, mais juste moins pour plus de préjudices » – et plus de bénéfices. Dans la mode, les mannequins virtuels permettent de créer un semblant de diversité, alors qu’en réalité, ils réduisent les opportunités des mannequins issus de la diversité.

Babysitter les IA : l’exploitation est la norme

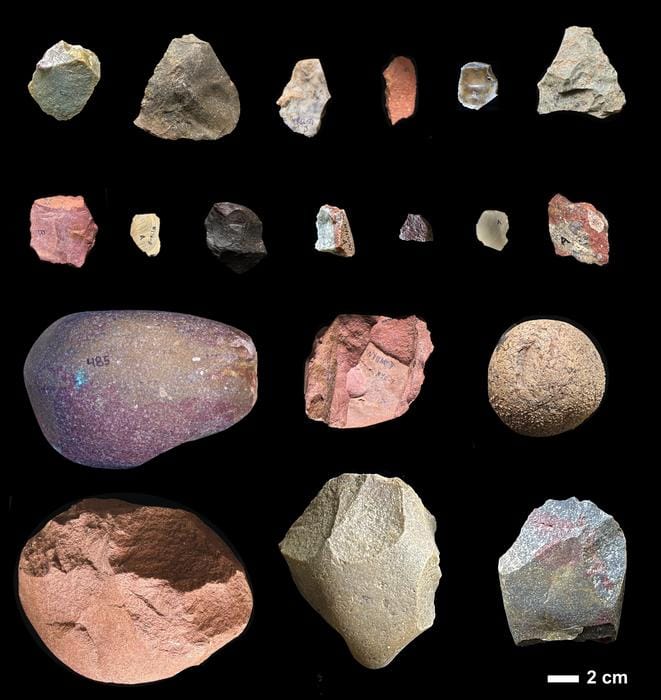

Dans cette perspective, le travail avec l’IA consiste de plus en plus à corriger leurs erreurs, à nettoyer, à être les babysitters de l’IA. Des babysitters de plus en plus invisibilisés. Les robotaxis autonomes de Cruise sont monitorés et contrôlés à distance. Tous les outils d’IA ont recours à un travail caché, invisible, externalisé. Et ce dès l’origine, puisqu’ImageNet, le projet fondateur de l’IA qui consistait à labelliser des images pour servir à l’entraînement des machines n’aurait pas été possible sans l’usage du service Mechanical Turk d’Amazon. 50 000 travailleurs depuis 167 pays ont été mobilisés pour créer le dataset qui a permis à l’IA de décoller. « Le modèle d’ImageNet consistant à exploiter des travailleurs à la tâche tout autour du monde est devenue une norme industrielle du secteur« . Aujourd’hui encore, le recours aux travailleurs du clic est persistant, notamment pour la correction des IA. Et les industries de l’IA profitent d’abord et avant tout l’absence de protection des travailleurs qu’ils exploitent.

Pas étonnant donc que les travailleurs tentent de répondre et de s’organiser, à l’image des scénaristes et des acteurs d’Hollywood et de leur 148 jours de grève. Mais toutes les professions ne sont pas aussi bien organisées. D’autres tentent d’autres méthodes, comme les outils des artistes visuels, Glaze et Nightshade, pour protéger leurs créations. Les travailleurs du clics eux aussi s’organisent, par exemple via l’African Content Moderators Union.

“Quand les services publics se tournent vers des solutions automatisées, c’est bien plus pour se décharger de leurs responsabilités que pour améliorer leurs réponses”

L’escroquerie de l’IA se développe également dans les services sociaux. Sous prétexte d’austérité, les solutions automatisées sont partout envisagées comme « la seule voie à suivre pour les services gouvernementaux à court d’argent ». L’accès aux services sociaux est remplacé par des « contrefaçons bon marchés » pour ceux qui ne peuvent pas se payer les services de vrais professionnels. Ce qui est surtout un moyen d’élargir les inégalités au détriment de ceux qui sont déjà marginalisés. Bien sûr, les auteurs font référence ici à des sources que nous avons déjà mobilisés, notamment Virginia Eubanks. « L’automatisation dans le domaine du social au nom de l’efficacité ne rend les autorités efficaces que pour nuire aux plus démunis« . C’est par exemple le cas de la détention préventive. En 2024, 500 000 américains sont en prison parce qu’ils ne peuvent pas payer leurs cautions. Pour remédier à cela, plusieurs Etats ont recours à des solutions algorithmiques pour évaluer le risque de récidive sans résoudre le problème, au contraire, puisque ces calculs ont surtout servi à accabler les plus démunis. A nouveau, « l’automatisation partout vise bien plus à abdiquer la gouvernance qu’à l’améliorer ».

“De partout, quand les services publics se tournent vers des solutions automatisées, c’est bien plus pour se décharger de leurs responsabilités que pour améliorer leurs réponses”, constatent, désabusées, Bender et Hanna. Et ce n’est pas qu’une caractéristique des autorités républicaines, se lamentent les chercheuses. Gavin Newsom, le gouverneur démocrate de la Californie démultiplie les projets d’IA générative, par exemple pour adresser le problème des populations sans domiciles afin de mieux identifier la disponibilité des refuges… « Les machines à extruder du texte pourtant, ne savent que faire cela, pas extruder des abris ». De partout d’ailleurs, toutes les autorités publiques ont des projets de développement de chatbots et des projets de systèmes d’IA pour résoudre les problèmes de société. Les autorités oublient que ce qui affecte la santé, la vie et la liberté des gens nécessite des réponses politiques, pas des artifices artificiels.

Les deux chercheuses multiplient les exemples d’outils défaillants… dans un inventaire sans fin. Pourtant, rappellent-elles, la confiance dans ces outils reposent sur la qualité de leur évaluation. Celle-ci est pourtant de plus en plus le parent pauvre de ces outils, comme le regrettaient Sayash Kapoor et Arvind Narayanan dans leur livre. En fait, l’évaluation elle-même est restée déficiente, rappellent Hanna et Bender. Les tests sont partiels, biaisés par les données d’entraînements qui sont rarement représentatives. Les outils d’évaluation de la transcription automatique par exemple reposent sur le taux de mots erronés, mais comptent tout mots comme étant équivalent, alors que certains peuvent être bien plus importants que d’autres en contexte, par exemple, l’adresse est une donnée très importante quand on appelle un service d’urgence, or, c’est là que les erreurs sont les plus fortes.

« L’IA n’est qu’un pauvre facsimilé de l’Etat providence »

Depuis l’arrivée de l’IA générative, l’évaluation semble même avoir déraillé (voir notre article « De la difficulté à évaluer l’IA »). Désormais, ils deviennent des concours (par exemple en tentant de les classer selon leur réponses à des tests de QI) et des outils de classements pour eux-mêmes, comme s’en inquiétaient déjà les chercheuses dans un article de recherche. La capacité des modèles d’IA générative à performer aux évaluations tient d’un effet Hans le malin, du nom du cheval qui avait appris à décoder les signes de son maître pour faire croire qu’il était capable de compter. On fait passer des tests qu’on propose aux professionnels pour évaluer ces systèmes d’IA, alors qu’ils ne sont pas faits pour eux et qu’ils n’évaluent pas tout ce qu’on regarde au-delà des tests pour ces professions, comme la créativité, le soin aux autres. Malgré les innombrables défaillances d’outils dans le domaine de la santé (on se souvient des algorithmes défaillants de l’assureur UnitedHealth qui produisait des refus de soins deux fois plus élevés que ses concurrents ou ceux d’Epic Systems ou d’autres encore pour allouer des soins, dénoncés par l’association nationale des infirmières…), cela n’empêche pas les outils de proliférer. Amazon avec One Medical explore le triage de patients en utilisant des chatbots, Hippocratic AI lève des centaines de millions de dollars pour produire d’épouvantables chatbots spécialisés. Et ne parlons pas des chatbots utilisés comme psy et coach personnels, aussi inappropriés que l’était Eliza il y a 55 ans… Le fait de pousser l’IA dans la santé n’a pas d’autres buts que de dégrader les conditions de travail des professionnels et d’élargir le fossé entre ceux qui seront capables de payer pour obtenir des soins et les autres qui seront laissés aux « contrefaçons électroniques bon marchés ». Les chercheuses font le même constat dans le développement de l’IA dans le domaine scolaire, où, pour contrer la généralisation de l’usage des outils par les élèves, les institutions investissent dans des outils de détection défaillants qui visent à surveiller et punir les élèves plutôt que les aider, et qui punissent plus fortement les étudiants en difficultés. D’un côté, les outils promettent aux élèves d’étendre leur créativité, de l’autre, ils sont surtout utilisés pour renforcer la surveillance. « Les étudiants n’ont pourtant pas besoin de plus de technologie. Ils ont besoin de plus de professeurs, de meilleurs équipements et de plus d’équipes supports ». Confrontés à l’IA générative, le secteur a du mal à s’adapter expliquait Taylor Swaak pour le Chronicle of Higher Education (voir notre récent dossier sur le sujet). Dans ce secteur comme dans tous les autres, l’IA est surtout vue comme un moyen de réduire les coûts. C’est oublier que l’école est là pour accompagner les élèves, pour apprendre à travailler et que c’est un apprentissage qui prend du temps. L’IA est finalement bien plus le symptôme des problèmes de l’école qu’une solution. Elle n’aidera pas à mieux payer les enseignants ou à convaincre les élèves de travailler…

Dans le social, la santé ou l’éducation, le développement de l’IA est obnubilé par l’efficacité organisationnelle : tout l’enjeu est de faire plus avec moins. L’IA est la solution de remplacement bon marché. « L’IA n’est qu’un pauvre facsimilé de l’Etat providence ». « Elle propose à tous ce que les techs barons ne voudraient pas pour eux-mêmes ». « Les machines qui produisent du texte synthétique ne combleront pas les lacunes de la fabrique du social ».

On pourrait généraliser le constat que nous faisions avec Clearview : l’investissement dans ces outils est un levier d’investissement idéologique qui vise à créer des outils pour contourner et réduire l’État providence, modifier les modèles économiques et politiques.

L’IA, une machine à produire des dommages sociaux

« Nous habitons un écosystème d’information qui consiste à établir des relations de confiance entre des publications et leurs lecteurs. Quand les textes synthétiques se déversent dans cet écosystème, c’est une forme de pollution qui endommage les relations comme la confiance ». Or l’IA promet de faire de l’art bon marché. Ce sont des outils de démocratisation de la créativité, explique par exemple le fondateur de Stability AI, Emad Mostaque. La vérité n’est pourtant pas celle-ci. L’artiste Karla Ortiz, qui a travaillé pour Marvel ou Industrial Light and Magic, expliquait qu’elle a très tôt perdu des revenus du fait de la concurrence initiée par l’IA. Là encore, les systèmes de génération d’image sont déployés pour perturber le modèle économique existant permettant à des gens de faire carrière de leur art. Tous les domaines de la création sont en train d’être déstabilisés. Les “livres extrudés” se démultiplient pour tenter de concurrencer ceux d’auteurs existants ou tromper les acheteurs. Dire que l’IA peut faire de l’art, c’est pourtant mal comprendre que l’art porte toujours une intention que les générateurs ne peuvent apporter. L’art sous IA est asocial, explique la sociologue Jennifer Lena. Quand la pratique artistique est une activité sociale, forte de ses pratiques éthiques comme la citation scientifique. La génération d’images, elle, est surtout une génération de travail dérivé qui copie et plagie l’existant. L’argument génératif semble surtout sonner creux, tant les productions sont souvent identiques aux données depuis lesquelles les textes et images sont formés, soulignent Bender et Hanna. Le projet Galactica de Meta, soutenu par Yann Le Cun lui-même, qui promettait de synthétiser la littérature scientifique et d’en produire, a rapidement été dépublié. « Avec les LLM, la situation est pire que le garbage in/garbage out que l’on connaît” (c’est-à-dire, le fait que si les données d’entrées sont mauvaises, les résultats de sortie le seront aussi). Les LLM produisent du « papier-mâché des données d’entraînement, les écrasant et remixant dans de nouvelles formes qui ne savent pas préserver l’intention des données originelles”. Les promesses de l’IA pour la science répètent qu’elle va pouvoir accélérer la science. C’était l’objectif du grand défi, lancé en 2016 par le chercheur de chez Sony, Hiroaki Kitano : concevoir un système d’IA pour faire des découvertes majeures dans les sciences biomédicales (le grand challenge a été renommé, en 2021, le Nobel Turing Challenge). Là encore, le défi a fait long feu. « Nous ne pouvons déléguer la science, car la science n’est pas seulement une collection de réponses. C’est d’abord un ensemble de processus et de savoirs ». Or, pour les thuriféraires de l’IA, la connaissance scientifique ne serait qu’un empilement, qu’une collection de faits empiriques qui seraient découverts uniquement via des procédés techniques à raffiner. Cette fausse compréhension de la science ne la voit jamais comme l’activité humaine et sociale qu’elle est avant tout. Comme dans l’art, les promoteurs de l’IA ne voient la science que comme des idées, jamais comme une communauté de pratique.

Cette vision de la science explique qu’elle devienne une source de solutions pour résoudre les problèmes sociaux et politiques, dominée par la science informatique, en passe de devenir l’autorité scientifique ultime, le principe organisateur de la science. La surutilisation de l’IA en science risque pourtant bien plus de rendre la science moins innovante et plus vulnérable aux erreurs, estiment les chercheuses. « La prolifération des outils d’IA en science risque d’introduire une phase de recherche scientifique où nous produisons plus, mais comprenons moins« , expliquaient dans Nature Lisa Messeri et M. J. Crockett (sans compter le risque de voir les compétences diminuer, comme le soulignait une récente étude sur la difficulté des spécialistes de l’imagerie médicale à détecter des problèmes sans assistance). L’IA propose surtout un point de vue non situé, une vue depuis nulle part, comme le dénonçait Donna Haraway : elle repose sur l’idée qu’il y aurait une connaissance objective indépendante de l’expérience. « L’IA pour la science nous fait croire que l’on peut trouver des solutions en limitant nos regards à ce qui est éclairé par la lumière des centres de données ». Or, ce qui explique le développement de l’IA scientifique n’est pas la science, mais le capital-risque et les big-tech. L’IA rend surtout les publications scientifiques moins fiables. Bien sûr, cela ne signifie pas qu’il faut rejeter en bloc l’automatisation des instruments scientifiques, mais l’usage généralisé de l’IA risque d’amener plus de risques que de bienfaits.

Mêmes constats dans le monde de la presse, où les chercheuses dénoncent la prolifération de « moulins à contenus”, où l’automatisation fait des ravages dans un secteur déjà en grande difficulté économique. L’introduction de l’IA dans les domaines des arts, de la science ou du journalisme constitue une même cible de choix qui permet aux promoteurs de l’IA de faire croire en l’intelligence de leurs services. Pourtant, leurs productions ne sont pas des preuves de la créativité de ces machines. Sans la créativité des travailleurs qui produisent l’art, la science et le journalisme qui alimentent ces machines, ces machines ne sauraient rien produire. Les contenus synthétiques sont tous basés sur le vol de données et l’exploitation du travail d’autrui. Et l’utilisation de l’IA générative produit d’abord des dommages sociaux dans ces secteurs.

Le risque de l’IA, mais lequel et pour qui ?

Le dernier chapitre du livre revient sur les doomers et les boosters, en renvoyant dos à dos ceux qui pensent que le développement de l’IA est dangereux et les accélérationnistes qui pensent que le développement de l’IA permettra de sauver l’humanité. Pour les uns comme pour les autres, les machines sont la prochaine étape de l’évolution. Ces visions apocalyptiques ont produit un champ de recherche dédié, appelé l’AI Safety. Mais, contrairement à ce qu’il laisse entendre, ce champ disciplinaire ne vient pas de l’ingénierie de la sécurité et ne s’intéresse pas vraiment aux dommages que l’IA engendre depuis ses biais et défaillances. C’est un domaine de recherche centré sur les risques existentiels de l’IA qui dispose déjà d’innombrables centres de recherches dédiés.

Pour éviter que l’IA ne devienne immaîtrisable, beaucoup estiment qu’elle devrait être alignée avec les normes et valeurs humaines. Cette question de l’alignement est considérée comme le Graal de la sécurité pour ceux qui oeuvrent au développement d’une IA superintelligente (OpenAI avait annoncé travailler en 2023 à une superintelligence avec une équipe dédié au « super-alignement », mais l’entreprise à dissous son équipe moins d’un an après son annonce. Ilya Sutskever, qui pilotait l’équipe, a lancé depuis Safe Superintelligence Inc). Derrière l’idée de l’alignement, repose d’abord l’idée que le développement de l’IA serait inévitable. Rien n’est moins sûr, rappellent les chercheuses. La plupart des gens sur la planète n’ont pas besoin d’IA. Et le développement d’outils d’automatisation de masse n’est pas socialement désirable. « Ces technologies servent d’abord à centraliser le pouvoir, à amasser des données, à générer du profit, plutôt qu’à fournir des technologies qui soient socialement bénéfiques à tous ». L’autre problème, c’est que l’alignement de l’IA sur les « valeurs humaines » peine à les définir. Les droits et libertés ne sont des concepts qui ne sont ni universels ni homogènes dans le temps et l’espace. La déclaration des droits de l’homme elle-même s’est longtemps accomodé de l’esclavage. Avec quelles valeurs humaines les outils d’IA s’alignent-ils quand ils sont utilisés pour armer des robots tueurs, pour la militarisation des frontières ou la traque des migrants ?, ironisent avec pertinence Bender et Hanna.

Pour les tenants du risque existentiel de l’IA, les risques existentiels dont il faudrait se prémunir sont avant tout ceux qui menacent la prospérité des riches occidentaux qui déploient l’IA, ironisent-elles encore. Enfin, rappellent les chercheuses, les scientifiques qui travaillent à pointer les risques réels et actuels de l’IA et ceux qui œuvrent à prévenir les risques existentiels ne travaillent pas à la même chose. Les premiers sont entièrement concernés par les enjeux sociaux, raciaux, dénoncent les violences et les inégalités, quand les seconds ne dénoncent que des risques hypothétiques. Les deux champs scientifiques ne se recoupent ni ne se citent entre eux.

Derrière la fausse guerre entre doomers et boomers, les uns se cachent avec les autres. Pour les uns comme pour les autres, le capitalisme est la seule solution aux maux de la société. Les uns comme les autres voient l’IA comme inévitable et désirable parce qu’elle leur promet des marchés sans entraves. Pourtant, rappellent les chercheuses, le danger n’est pas celui d’une IA qui nous exterminerait. Le danger, bien présent, est celui d’une spéculation financière sans limite, d’une dégradation de la confiance dans les médias à laquelle l’IA participe activement, la normalisation du vol de données et de leur exploitation et le renforcement de systèmes imaginés pour punir les plus démunis. Doomers et boosters devraient surtout être ignorés, s’ils n’étaient pas si riches et si influents. L’emphase sur les risques existentiels détournent les autorités des régulations qu’elles devraient produire.

Pour répondre aux défis de la modernité, nous n’avons pas besoin de générateur de textes, mais de gens, de volonté politique et de ressources, concluent les chercheuses. Nous devons collectivement façonner l’innovation pour qu’elle bénéficie à tous plutôt qu’elle n’enrichisse certains. Pour résister à la hype de l’IA, nous devons poser de meilleures questions sur les systèmes qui se déploient. D’où viennent les données ? Qu’est-ce qui est vraiment automatisé ? Nous devrions refuser de les anthropomorphismer : il ne peut y avoir d’infirmière ou de prof IA. Nous devrions exiger de bien meilleures évaluations des systèmes. ShotSpotter, le système vendu aux municipalités américaines pour détecter automatiquement le son des coups de feux, était annoncé avec un taux de performance de 97% (et un taux de faux positif de 0,5% – et c’est encore le cas dans sa FAQ). En réalité, les audits réalisés à Chicago et New York ont montré que 87 à 91% des alertes du systèmes étaient de fausses alertes ! Nous devons savoir qui bénéficie de ces technologies, qui en souffre. Quels recours sont disponibles et est-ce que le service de plainte est fonctionnel pour y répondre ?

Face à l’IA, nous devons avoir aucune confiance

Pour les deux chercheuses, la résistance à l’IA passe d’abord et avant tout par luttes collectives. C’est à chacun et à tous de boycotter ces produits, de nous moquer de ceux qui les utilisent. C’est à nous de rendre l’usage des médias synthétiques pour ce qu’ils sont : inutiles et ringards. Pour les deux chercheuses, la résistance à ces déploiements est essentielle, tant les géants de l’IA sont en train de l’imposer, par exemple dans notre rapport à l’information, mais également dans tous leurs outils. C’est à nous de refuser « l’apparente commodité des réponses des chatbots ». C’est à nous d’oeuvrer pour renforcer la régulation de l’IA, comme les lois qui protègent les droits des travailleurs, qui limitent la surveillance.

Emily Bender et Alex Hanna plaident pour une confiance zéro à l’encontre de ceux qui déploient des outils d’IA. Ces principes établis par l’AI Now Institute, Accountable Tech et l’Electronic Privacy Information Center, reposent sur 3 leviers : renforcer les lois existantes, établir des lignes rouges sur les usages inacceptables de l’IA et exiger des entreprises d’IA qu’elles produisent les preuves que leurs produits sont sans dangers.

Mais la régulation n’est hélas pas à l’ordre du jour. Les thuriféraires de l’IA défendent une innovation sans plus aucune entrave afin que rien n’empêche leur capacité à accumuler puissance et fortune. Pour améliorer la régulation, nous avons besoin d’une plus grande transparence, car il n’y aura pas de responsabilité sans elle, soulignent les chercheuses. Nous devons avoir également une transparence sur l’automatisation à l’œuvre, c’est-à-dire que nous devons savoir quand nous interagissons avec un système, quand un texte a été traduit automatiquement. Nous avons le droit de savoir quand nous sommes les sujets soumis aux résultats de l’automatisation. Enfin, nous devons déplacer la responsabilité sur les systèmes eux-mêmes et tout le long de la chaîne de production de l’IA. Les entreprises de l’IA doivent être responsables des données, du travail qu’elles réalisent sur celles-ci, des modèles qu’elles développent et des évaluations. Enfin, il faut améliorer les recours, le droit des données et la minimisation. En entraînant leurs modèles sur toutes les données disponibles, les entreprises de l’IA ont renforcé la nécessité d’augmenter les droits des gens sur leurs données. Enfin, elles plaident pour renforcer les protections du travail en donnant plus de contrôle aux travailleurs sur les outils qui sont déployés et renforcer le droit syndical. Nous devons œuvrer à des « technologies socialement situées », des outils spécifiques plutôt que des outils qui sauraient tout faire. Les applications devraient bien plus respecter les droits des usagers et par exemple ne pas autoriser la collecte de leurs données. Nous devrions enfin défendre un droit à ne pas être évalué par les machines. Comme le dit Ruha Benjamin, en défendant la Justice virale (Princeton University Press, 2022), nous devrions œuvrer à “un monde où la justice est irrésistible”, où rien ne devrait pouvoir se faire pour les gens sans les gens. Nous avons le pouvoir de dire non. Nous devrions refuser la reconnaissance faciale et émotionnelle, car, comme le dit Sarah Hamid du réseau de résistance aux technologies carcérales, au-delà des biais, les technologies sont racistes parce qu’on le leur demande. Nous devons les refuser, comme l’Algorithmic Justice League recommande aux voyageurs de refuser de passer les scanneurs de la reconnaissance faciale.

Bender et Hanna nous invitent à activement résister à la hype. A réaffirmer notre valeur, nos compétences et nos expertises sur celles des machines. Les deux chercheuses ne tiennent pas un propos révolutionnaire pourtant. Elles ne livrent qu’une synthèse, riche, informée. Elles ne nous invitent qu’à activer la résistance que nous devrions naturellement activer, mais qui semble être devenue étrangement radicale ou audacieuse face aux déploiements omnipotents de l’IA.

Hubert Guillaud