Pour une science de la subjectivité

« J’aimerais vous confronter à un problème de calcul difficile », attaque Albert Moukheiber sur la scène de la conférence USI 2025. « Dans les sciences cognitives, on est confronté à un problème qu’on n’arrive pas à résoudre : la subjectivité ! »

Le docteur en neuroscience et psychologue clinicien, auteur de Votre cerveau vous joue des tours (Allary éditions 2019) et de Neuromania (Allary éditions, 2024), commence par faire un rapide historique de ce qu’on sait sur le cerveau.

Où est le neurone ?

« Contrairement à d’autres organes, un cerveau mort n’a rien à dire sur son fonctionnement. Et pendant très longtemps, nous n’avons pas eu d’instruments pour comprendre un cerveau ». En fait, les technologies permettant d’ausculter le cerveau, de cartographier son activité, sont assez récentes et demeurent bien peu précises. Pour cela, il faut être capable de mesurer son activité, de voir où se font les afflux d’énergie et l’activité chimique. C’est seulement assez récemment, depuis les années 1990 surtout, qu’on a développé des technologies pour étudier cette activité, avec les électro-encéphalogrammes, puis avec l’imagerie par résonance magnétique (IRM) structurelle et surtout fonctionnelle. L’IRM fonctionnelle est celle que les médecins vous prescrivent. Elle mesure la matière cérébrale permettant de créer une image en noir et blanc pour identifier des maladies, des lésions, des tumeurs. Mais elle ne dit rien de l’activité neuronale. Seule l’IRM fonctionnelle observe l’activité, mais il faut comprendre que les images que nous en produisons sont peu précises et demeurent probabilistes. Les images de l’IRMf font apparaître des couleurs sur des zones en activité, mais ces couleurs ne désignent pas nécessairement une activité forte de ces zones, ni que le reste du cerveau est inactif. L’IRMf tente de montrer que certaines zones sont plus actives que d’autres parce qu’elles sont plus alimentées en oxygène et en sang. L’IRMf fonctionne par soustraction des images passées. Le patient dont on mesure l’activité cérébrale est invité à faire une tâche en limitant au maximum toute autre activité que celle demandée et les scientifiques comparent ces images à des précédentes pour déterminer quelles zones sont affectées quand vous fermez le poing par exemple. « On applique des calculs de probabilité aux soustractions pour tenter d’isoler un signal dans un océan de bruits », précise Moukheiber dans Neuromania. L’IRMf n’est donc pas un enregistrement direct de l’activation cérébrale pour une tâche donnée, mais « une reconstruction a posteriori de la probabilité qu’une aire soit impliquée dans cette tâche ». En fait, les couleurs indiquent des probabilités. « Ces couleurs n’indiquent donc pas une intensité d’activité, mais une probabilité d’implication ». Enfin, les mesures que nous réalisons n’ont rien de précis, rappelle le chercheur. La précision de l’IRMf est le voxel, qui contient environ 5,5 millions de neurones ! Ensuite, l’IRMf capture le taux d’oxygène, alors que la circulation sanguine est bien plus lente que les échanges chimiques de nos neurones. Enfin, le traitement de données est particulièrement complexe. Une étude a chargé plusieurs équipes d’analyser un même ensemble de données d’IRMf et n’a pas conduit aux mêmes résultats selon les équipes. Bref, pour le dire simplement, le neurone est l’unité de base de compréhension de notre cerveau, mais nos outils ne nous permettent pas de le mesurer. Il faut dire qu’il n’est pas non plus le bon niveau explicatif. Les explications établies à partir d’images issues de l’IRMf nous donnent donc plus une illusion de connaissance réelle qu’autre chose. D’où l’enjeu à prendre les résultats de nombre d’études qui s’appuient sur ces images avec beaucoup de recul. « On peut faire dire beaucoup de choses à l’imagerie cérébrale » et c’est assurément ce qui explique qu’elle soit si utilisée.

Les données ne suffisent pas

Dans les années 50-60, le courant de la cybernétique pensait le cerveau comme un organe de traitement de l’information, qu’on devrait étudier comme d’autres machines. C’est la naissance de la neuroscience computationnelle qui tente de modéliser le cerveau à l’image des machines. Outre les travaux de John von Neumann, Claude Shannon prolonge ces idées d’une théorie de l’information qui va permettre de créer des « neurones artificiels », qui ne portent ce nom que parce qu’ils ont été créés pour fonctionner sur le modèle d’un neurone. En 1957, le Perceptron de Frank Rosenblatt est considéré comme la première machine à utiliser un réseau neuronal artificiel. Mais on a bien plus appliqué le lexique du cerveau aux ordinateurs qu’autre chose, rappelle Albert Moukheiber.

Aujourd’hui, l’Intelligence artificielle et ses « réseaux de neurones » n’a plus rien à voir avec la façon dont fonctionne le cerveau, mais les neurosciences computationnelles, elles continuent, notamment pour aider à faire des prothèses adaptées comme les BCI, Brain Computer Interfaces.

Désormais, faire de la science consiste à essayer de comprendre comment fonctionne le monde naturel depuis un modèle. Jusqu’à récemment, on pensait qu’il fallait des théories pour savoir quoi faire des données, mais depuis l’avènement des traitements probabilistes et du Big Data, les modèles théoriques sont devenus inutiles, comme l’expliquait Chris Anderson dans The End of Theory en 2008. En 2017, des chercheurs se sont tout de même demandé si l’on pouvait renverser l’analogie cerveau-ordinateur en tentant de comprendre le fonctionnement d’un microprocesseur depuis les outils des neurosciences. Malgré l’arsenal d’outils à leur disposition, les chercheurs qui s’y sont essayé ont été incapables de produire un modèle de son fonctionnement. Cela nous montre que comprendre un fonctionnement ne nécessite pas seulement des informations techniques ou des données, mais avant tout des concepts pour les organiser. En fait, avoir accès à une quantité illimitée de données ne suffit pas à comprendre ni le processeur ni le cerveau. En 1974, le philosophe des sciences, Thomas Nagel, avait proposé une expérience de pensée avec son article « Quel effet ça fait d’être une chauve-souris ? ». Même si l’on connaissait tout d’une chauve-souris, on ne pourra jamais savoir ce que ça fait d’être une chauve-souris. Cela signifie qu’on ne peut jamais atteindre la vie intérieure d’autrui. Que la subjectivité des autres nous échappe toujours. C’est là le difficile problème de la conscience.

La subjectivité nous échappe

Une émotion désigne trois choses distinctes, rappelle Albert Moukheiber. C’est un état biologique qu’on peut tenter d’objectiver en trouvant des modalités de mesure, comme le tonus musculaire. C’est un concept culturel qui a des ancrages et valeurs très différentes d’une culture l’autre. Mais c’est aussi et d’abord un ressenti subjectif. Ainsi, par exemple, le fait de se sentir triste n’est pas mesurable. « On peut parfaitement comprendre le cortex moteur et visuel, mais on ne comprend pas nécessairement ce qu’éprouve le narrateur de Proust quand il mange la fameuse madeleine. Dix personnes peuvent être émues par un même coucher de soleil, mais sont-elles émues de la même manière ? »

Notre réductionnisme objectivant est là confronté à des situations qu’il est difficile de mesurer. Ce qui n’est pas sans poser problèmes, notamment dans le monde de l’entreprise comme dans celui de la santé mentale.

Le monde de l’entreprise a créé d’innombrables indicateurs pour tenter de mesurer la performance des salariés et collaborateurs. Il n’est pas le seul, s’amuse le chercheur sur scène. Les notes des étudiants leurs rappellent que le but est de réussir les examens plus que d’apprendre. C’est la logique de la loi de Goodhart : quand la mesure devient la cible, elle n’est plus une bonne mesure. Pour obtenir des bonus financiers liés au nombre d’opérations réussies, les chirurgiens réalisent bien plus d’opérations faciles que de compliquées. Quand on mesure les humains, ils ont tendance à modifier leur comportement pour se conformer à la mesure, ce qui n’est pas sans effets rebond, à l’image du célèbre effet cobra, où le régime colonial britannique offrit une prime aux habitants de Delhi qui rapporteraient des cobras morts pour les éradiquer, mais qui a poussé à leur démultiplication pour toucher la prime. En entreprises, nombre de mesures réalisées perdent ainsi très vite de leur effectivité. Moukheiber rappelle que les innombrables tests de personnalité ne valent pas mieux qu’un horoscope. L’un des tests le plus utilisé reste le MBTI qui a été développé dans les années 30 par des personnes sans aucune formation en psychologie. Non seulement ces tests n’ont aucun cadre théorique (voir ce que nous en disait le psychologue Alexandre Saint-Jevin, il y a quelques années), mais surtout, « ce sont nos croyances qui sont déphasées. Beaucoup de personnes pensent que la personnalité des individus serait centrale dans le cadre professionnel. C’est oublier que Steve Jobs était surtout un bel enfoiré ! », comme nombre de ces « grands » entrepreneurs que trop de gens portent aux nues. Comme nous le rappelions nous-mêmes, la recherche montre en effet que les tests de personnalités peinent à mesurer la performance au travail et que celle-ci a d’ailleurs peu à voir avec la personnalité. « Ces tests nous demandent d’y répondre personnellement, quand ce devrait être d’abord à nos collègues de les passer pour nous », ironise Moukheiber. Ils supposent surtout que la personnalité serait « stable », ce qui n’est certainement pas si vrai. Enfin, ces tests oublient que bien d’autres facteurs ont peut-être bien plus d’importance que la personnalité : les compétences, le fait de bien s’entendre avec les autres, le niveau de rémunération, le cadre de travail… Mais surtout, ils ont tous un effet « barnum » : n’importe qui est capable de se reconnaître dedans. Dans ces tests, les résultats sont toujours positifs, même les gens les plus sadiques seront flattés des résultats. Bref, vous pouvez les passer à la broyeuse.

Dans le domaine de la santé mentale, la mesure de la subjectivité est très difficile et son absence très handicapante. La santé mentale est souvent vue comme une discipline objectivable, comme le reste de la santé. Le modèle biomédical repose sur l’idée qu’il suffit d’ôter le pathogène pour aller mieux. Il suffirait alors d’enlever les troubles mentaux pour enlever le pathogène. Bien sûr, ce n’est pas le cas. « Imaginez un moment, vous êtes une femme brillante de 45 ans, star montante de son domaine, travaillant dans une entreprise où vous êtes très valorisée. Vous êtes débauché par la concurrence, une entreprise encore plus brillante où vous allez pouvoir briller encore plus. Mais voilà, vous y subissez des remarques sexistes permanentes, tant et si bien que vous vous sentez moins bien, que vous perdez confiance, que vous développez un trouble anxieux. On va alors pousser la personne à se soigner… Mais le pathogène n’est ici pas en elle, il est dans son environnement. N’est-ce pas ici ses collègues qu’il faudrait pousser à se faire soigner ? »

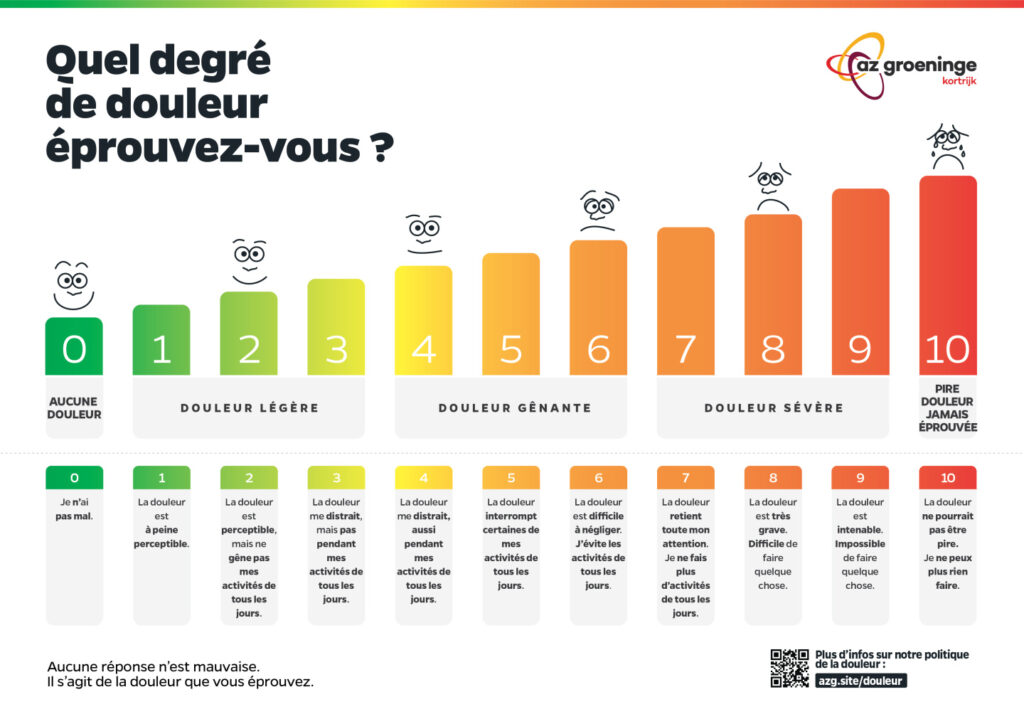

En médecine, on veut toujours mesurer les choses. Mais certaines restent insondables. Pour mesurer la douleur, il existe une échelle de la douleur.

« Mais deux personnes confrontés à la même blessure ne vont pas l’exprimer au même endroit sur l’échelle de la douleur. La douleur n’est pas objectivable. On ne peut connaître que les douleurs qu’on a vécu, à laquelle on les compare ». Mais chacun a une échelle de comparaison différente, car personnelle. « Et puis surtout, on est très doué pour ne pas croire et écouter les gens. C’est ainsi que l’endométriose a mis des années pour devenir un problème de santé publique. Une femme à 50% de chance d’être qualifiée en crise de panique quand elle fait un AVC qu’un homme »… Les exemples en ce sens sont innombrables. « Notre obsession à tout mesurer finit par nier l’existence de la subjectivité ». Rapportée à moi, ma douleur est réelle et handicapante. Rapportée aux autres, ma douleur n’est bien souvent perçue que comme une façon de se plaindre. « Les sciences cognitives ont pourtant besoin de meilleures approches pour prendre en compte cette phénoménologie. Nous avons besoin d’imaginer les moyens de mesurer la subjectivité et de la prendre plus au sérieux qu’elle n’est ».

La science de la subjectivité n’est pas dénuée de tentatives de mesure, mais elles sont souvent balayées de la main, alors qu’elles sont souvent plus fiables que les mesures dites objectives. « Demander à quelqu’un comment il va est souvent plus parlant que les mesures électrodermales qu’on peut réaliser ». Reste que les mesures physiologiques restent toujours très séduisantes que d’écouter un patient, un peu comme quand vous ajoutez une image d’une IRM à un article pour le rendre plus sérieux qu’il n’est.

*

Pour conclure la journée, Christian Fauré, directeur scientifique d’Octo Technology revenait sur son thème, l’incalculabilité. « Trop souvent, décider c’est calculer. Nos décisions ne dépendraient plus alors que d’une puissance de calcul, comme nous le racontent les chantres de l’IA qui s’empressent à nous vendre la plus puissante. Nos décisions sont-elles le fruit d’un calcul ? Nos modèles d’affaires dépendent-ils d’un calcul ? Au tout début d’OpenAI, Sam Altman promettait d’utiliser l’IA pour trouver un modèle économique à OpenAI. Pour lui, décider n’est rien d’autre que calculer. Et le calcul semble pouvoir s’appliquer à tout. Certains espaces échappent encore, comme vient de le dire Albert Moukheiber. Tout n’est pas calculable. Le calcul ne va pas tout résoudre. Cela semble difficile à croire quand tout est désormais analysé, soupesé, mesuré« . « Il faut qu’il y ait dans le poème un nombre tel qu’il empêche de compter », disait Paul Claudel. Le poème n’est pas que de la mesure et du calcul, voulait dire Claudel. Il faut qu’il reste de l’incalculable, même chez le comptable, sinon à quoi bon faire ces métiers. « L’incalculable, c’est ce qui donne du sens ».

« Nous vivons dans un monde où le calcul est partout… Mais il ne donne pas toutes les réponses. Et notamment, il ne donne pas de sens, comme disait Pascal Chabot. Claude Shannon, dit à ses collègues de ne pas donner de sens et de signification dans les données. Turing qui invente l’ordinateur, explique que c’est une procédure univoque, c’est-à-dire qu’elle est reliée à un langage qui n’a qu’un sens, comme le zéro et le un. Comme si finalement, dans cette abstraction pure, réduite à l’essentiel, il était impossible de percevoir le sens ».

Hubert Guillaud